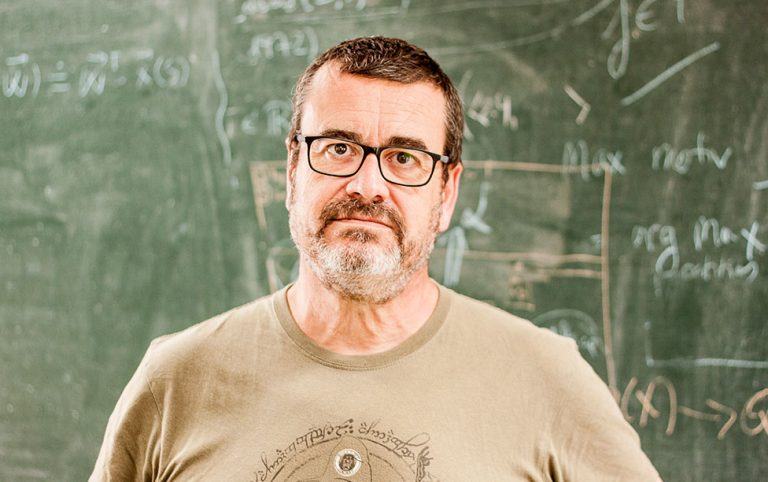

Carles Sierra es, sin exagerar, una de las personas que más entiende de inteligencia artificial en España y Europa. Profesor de Investigación y Director del Instituto de Investigación en Inteligencia Artificial (IIIA) del Consejo Superior de Investigaciones Científicas (CSIC), también es profesor adjunto de la Universidad de Western Sydney, y orgulloso ganador del Premio de Investigación de Agentes Autónomos ACM/SIGAI 2019. Ante la rápida expansión de la inteligencia artificial, la todavía falta de regulación y el uso de sistemas como ChatGPT, conversamos con él para aclarar más este concepto y saber hacia dónde vamos.

¿Qué oportunidades nos ofrece actualmente la inteligencia artificial?

La IA es una tecnología muy transversal. Básicamente es una especialización de las ciencias de la computación, y lo que permite es la automatización de muchísimos procesos. Permite automatizar desde la conducción de un tractor hasta el análisis de texto, la generación de imágenes, la programación de robots… al ser transversal afecta y puede afectar a todas las esferas de la actividad humana. Esta automatización puede ser buena o no tan buena, dependerá de donde la apliquemos. Esta sería una reflexión genérica, pero es útil en medicina, en biología, en análisis de datos de satélites. Realmente su campo de actuación es muy variado.

Usted es uno de los firmantes del manifiesto que pide frenar la IA generativa, como por ejemplo ChatGPT.

No decimos que paremos la investigación en IA, la carta dice que la investigación en IA debe continuar porque su aplicación para hacer el bien a la humanidad es enorme y, por lo tanto, se debe seguir trabajando. Pero habla de un tipo de IA, que es la generativa, que lo que genera son textos o imágenes que son verosímiles, es decir, que parecen hechas por un humano. Pero eso no quiere decir que sean verdaderas. El fundamento matemático de cómo funcionan estas aplicaciones hace que sean así. Esto se entiende muy rápidamente: en el caso del texto, la base fundamental es la continuación de frases. Si yo le digo a ChatGPT “la casa es” y pongo esto de entrada en el sistema, éste debe generar una palabra de salida. ¿Cuál generará? Para decidirlo, lo que se ha hecho es “entrenar” al sistema, es decir, se le han dado millones de libros, documentos de internet, etc., de manera que lo que ha hecho son unas distribuciones de probabilidad.

Los sistemas como ChatGPT, de inteligencia artificial generativa, tendrán muchos problemas para ser certificados porque no están siendo transparentes.

Cuando aparece “la casa es”, la palabra que aparece más frecuentemente después es “grande”, después viene “roja”, después viene “bonita”. Entonces, tenemos un ranking de palabras que continúan este inicio de frase. Y el sistema no coge aquella probabilidad más alta, sino que lo hace de las que están bastante arriba. Tiene un parámetro, un elemento, que le hace escoger una de estas. Eso quiere decir que está generando texto nuevo, en el sentido de que, aunque haya sido entrenado con muchísimos libros, lo que generará será una versión nueva que no tiene por qué haber aparecido nunca en ninguno de los libros con los que ha sido entrenado. Esta elección de palabras de la banda alta hace que el resultado parezca generado por un humano. Si siempre escogiese la de probabilidad más alta, el texto resultaría un churro, no se entendería bien. Pero si la elección es en función de este parámetro, parece muy humano. Y este es el peligro, y donde viene el toque de alerta, es decir, no podemos confundir la verosimilitud con la verdad.

¿Entonces cuál es el objetivo de estos sistemas como ChatGPT?

El objetivo es ser verosímiles, no ser correctos. Aquí, el peligro es que la gente utilice estos sistemas y piense que lo que dice el sistema es correcto, porque lo ve verosímil. Es lo mismo que pasa con la robótica. Tienes una caja que te dice cosas o que hace cosas, y no le das importancia, pero si le pones una cabeza con ojos, una boca que sonríe, etc., y te está diciendo que te tomes tal medicamento o interactúa contigo, generas un elemento de empatía que hace que pienses que lo que dice el robot está bien, que se tiene que hacer, que se le tiene que obedecer… Porque tiene este elemento de verosimilitud humana. Es el mismo fenómeno. Y en este punto es donde la carta alerta de un peligro. No se trata de parar la investigación en general, sino de decir que lanzar estos sistemas y que sean accesibles para la población en general, sin haber hecho la verificación de requerimientos mínima a estos sistemas, es muy arriesgado y es irresponsable.

¿Y cómo está el tema de la carta y sus firmas en este momento? ¿En qué normas específicas trabaja la UE sobre la responsabilidad de la IA?

Estuve interactuando un poco con Stuart Russell, que es el segundo firmante, y la persona que conozco más personalmente, y la verdad es que al hacer esta carta no se pensaba en el eco que está teniendo, y no creo que tenga un más allá. Lo que sí es cierto es que ha levantado cierta polvareda, y ha hecho que mucha gente reaccione. Por ejemplo, el Parlamento Europeo, que iba muy poco a poco con la ley de regulación de la IA (hace como dos años que le van dando vueltas, y ya sabes a qué velocidad van las cosas en los parlamentos, porque se reúnen una vez al mes, las comisiones…), ha acelerado un poco. Me parece que a principios de mayo se enviaba la versión definitiva de la comisión correspondiente para su debate en el parlamento, y esta es la joya de la corona, esta regulación de la IA que aprobará, si todo va bien, durante este año el Parlamento Europeo.

Una de las patas de la estrategia catalana de IA en su vertiente empresarial es el CIDAI, donde las empresas pueden asesorarse en esta tecnología.

La ley tiene, básicamente, cuatro categorías. Prohíbe el reconocimiento facial en espacios públicos, a no ser que sea con orden judicial. Y el resto de sistemas quedan clasificados en tres categorías según su riesgo. En los de riesgo moderado y bajo, no hay una obligatoriedad de hacer muchas verificaciones o comprobaciones en los sistemas, pero a los de alto riesgo se les exige unos elementos, unas capacidades de transparencia (cómo se ha entrenado el sistema, cómo se han obtenido los datos, respeto a los derechos fundamentales de los trabajadores…), toda una serie de elementos y, al mismo tiempo, una capacidad de “explicabilidad” de los sistemas: cuando el sistema te diga algo, tú le puedas preguntar ¿por qué? y ha de ser capaz de responderte.

Y aquí es donde estos sistemas generativos tendrán muchos problemas para ser certificados, porque no están siendo transparentes. Estas grandes corporaciones no están explicando al detalle de dónde han obtenido los datos y cómo funcionan estos sistemas. Hay mucha opacidad en esto. Y luego está, la “explicabilidad”, porque no saben si lo que están generando es verdad o no. Si realmente el Parlamento Europeo clasifica estos sistemas como de alto riesgo, lo que puede pasar perfectamente es que, en la práctica, no puedan salir al mercado.

Ha habido una aceleración de las discusiones, en vista de la polvareda que se ha levantado sobre este tema. Hay que decir que, en mi opinión, ChatGPT y sistemas similares pueden ser útiles. Hacen muy bien algunas tareas, y no seré de los que critican totalmente estos sistemas. No siempre hemos de alegrarnos de lo que se puede hacer, sino que hemos de reflexionar sobre lo que se debe hacer, que son dos cosas muy diferentes.

¿El peligro está en que se use sin cuestionarse su funcionamiento?

A nivel tecnológico esto ha sido un avance importante, pero tenemos que ser cuidadosos porque la población general no tiene por qué entender bien cómo funciona. Un profesional puede entender bien las limitaciones de estos sistemas. Un periodista puede utilizarlo hasta cierto punto, puede comprobar si el resultado es cierto o no, puede contrastar. En un aula puede ser interesante para abrir debates, el sistema puede generar argumentos a favor de una idea o en contra de una idea, puede fomentar el espíritu crítico… Bien llevados, estos sistemas pueden tener una utilidad muy importante, pero no sabemos cómo sobrellevará esto la población general sin una supervisión en el uso del sistema. Estoy muy en contacto con educadores, porque es algo que me interesa mucho, y evidentemente lo que no podemos retrasar más es la educación en este tipo de tecnologías en los planes de estudio, desde primaria hasta la ESO, Bachillerato o FP. Los chicos y chicas tienen que saber los límites que tiene esta tecnología y hasta qué punto la pueden utilizar.

Pero, en el caso extremo en que esto pueda traer consecuencias más arriesgadas, creo que tienen que ser los poderes públicos los que intervengan. No todo vale por dinero, para que estas empresas consigan mucho dinero a partir de abrir esto y hacer alquileres, porque mucha gente se enganchará a este tema. ChatGPT me preocupa en el sentido de la población no educada, en cuanto esto le afecte en su vida personal. Por que tome decisiones basándose en lo que le diga el sistema que puedan ser erróneas. Que piensen que es cierto lo que le están diciendo, cuando es un constructo estadístico.

Ahora me han preocupado más un par de sistemas que han salido, Auto GPT y Agent GPT, porque son sistemas a los que les pides que hagan un plan para resolver una tarea y, no sólo lo hacen, sino que generan el código para ejecutar cada paso de este plan y lo ejecutan.

¿Qué son y cómo funcionan? ¿Por qué le preocupan más estos sistemas?

Esto abre una caja de Pandora enorme, porque cuando le doy al sistema un objetivo… Por ejemplo, si le digo al sistema que me envíe un email con el tiempo que hará en Barcelona esta noche, es una cosa muy sencilla, pero el sistema tiene que hacer tres cosas: hacer un scrapping de una web que dé datos meteorológicos sobre Barcelona, construir el texto de un email donde pondrá los datos obtenidos y enviar el email a la persona indicada. El sistema genera el código para hacer la primera tarea, genera el texto del correo, el código que incrusta la información en el email y, en el tercer paso, no puede ejecutarlo porque no tiene acceso a un cliente de correo que permita enviar mensajes. Si lo hubiera tenido, hubiera enviado el correo y no pasaría nada porque lo generado como plan estaba bien… Pero ¿qué pasa si no entiende lo que le pido, lo interpreta de otra manera y hace un plan para otra cosa que no es lo que yo quería? ¿Qué pasa si el código que genera no es, de hecho, el código correcto sino algo que puede provocar vete a saber qué problema en mi ordenador o en el ordenador de quién sea? ¿Qué pasa si este ordenador tiene acceso a dispositivos como el brazo de un robot y lo programa para hacer una tarea que es una barbaridad y puede provocar daños a otros? ¿Y si lo que yo le estoy diciendo es ilegal o que puede provocar daño?

Es decir, a estos sistemas se les tiene que poner un límite en lo que se les permite hacer o se les permite generar, y esto se debe regular. No puede ser que un ciudadano que no tiene conocimientos de esta tecnología le pida a un sistema que haga lo que sea y que se acabe ejecutando. Tenemos que intentar poner control a estas situaciones de riesgo. Y este es el espíritu de la carta.

La exigencia de responsabilidad, ¿para quién es? Ya ha habido demandas contra Open AI, diseñadores de ChatGPT.

El tema de la responsabilidad siempre está en manos de las empresas que están poniendo estos sistemas a disposición de la gente, evidentemente. No puede ser de otra manera. Quizás un abogado lo perfilaría más, pero creo que la responsabilidad ha de recaer en quien genera estos sistemas. Seguramente, en sus terms and conditions, dirán que no, que si eres tú el que haces un prompt, ellos no son responsables, que lo único que hacen es generar salidas, pero yo creo que legalmente ellos son responsables de lo que están generando.

Han tenido mucho cuidado, porque en sistemas anteriores, al interactuar con la gente, el sistema en unos días ya se había convertido en un nazi con un sistema que generaba discurso de odio, porque era lo que iba aprendiendo en su interacción, de alguna manera, y lo acabaron retirando porque se dieron cuenta de que no funcionaba. Cuando la ley esté aprobada tendrán que certificar sus sistemas y garantizar que no se violan los derechos humanos, que son transparentes, que respetan los derechos de los trabajadores, y toda una serie de elementos importantes.

Es como si dices “todavía no sabemos cómo funcionan los coches autónomos, pero los vamos a poner en el mercado”. Pues no, los coches autónomos, antes de que salgan a la carretera, deben verificar muy bien su funcionamiento. No puedes lanzar las cosas así. Open AI ha tirado por el camino del medio, y las empresas que iban con un poco más de precaución –Google, por ejemplo, llevaba mucho tiempo desarrollando esto, pero no lo sacaba al mercado, y también Microsoft–, lo han sacado. Y se entra en una carrera que es peligrosa.

El británico Geoffrey Hinton, pionero de la IA, ha dejado su trabajo en Google y dice que se arrepiente de haber dedicado su vida a este ámbito y avisa de los peligros de esta tecnología. ¿Le sorprende?

Geoffrey Hinton es uno de los padres del deep learning, no es firmante de la carta porque trabajaba para Google, pero está totalmente alineado con lo que pienso y lo que piensan todos los firmantes de la carta antes mencionada. Él comenta precisamente estos sistemas que generan código y lo ejecutan como el riesgo más inminente que nos podemos encontrar.

A la que se le de acceso a Agent GPT a controlar un ordenador de manera completa, es decir, que tenga las credenciales de root que le permitan hacer cualquier cosa, aquí puede pasar de todo. Desde que te equivoques y te borre todas las fotografías, hasta que empieces a enviar spam… Simplemente por error o por ignorancia.

¿Qué peso tiene la IA actualmente y cómo cree que evolucionará?

El último estudio cuando se hizo la estrategia catalana de IA, que es un documento con mucha información, si no me equivoco, cuando se hizo el análisis de la situación industrial hablaba –hace un año o poco más– de 1.800 millones de euros de impacto directo de esta industria. No es una monstruosidad, pero ya empieza a ser importante. El número de empresas es muy alto, y no sólo las empresas que tienen esto como tecnología de base –hablamos de centenares de empresas–, sino las que están utilizando y utilizarán estos sistemas, que son prácticamente todas. Si hasta ahora muchas empresas tenían sus reservas, esto ya se ha acabado, y todas las empresas se están planteando en estos momentos cómo afectará este tipo de tecnología a su modelo de negocio, porque no se puede ignorar.

¿De qué manera pueden aplicar la IA las empresas?

El tema es la automatización de procesos. Si necesitas una persona que se lea un informe de 30 páginas y haga un resumen de una página, quizás tengas tecnología que permita hacer esta tarea mucho más rápidamente, o ayudar a la persona que tiene que hacer el resumen para, de alguna manera, generarlo, retocarlo y hacer la tarea más rápida. Por lo tanto, hará mucho más eficientes muchos procesos que se hacen de manera rutinaria en las empresas.

Es posible que, aunque sea inicialmente, se puedan hacer estas tareas muy bien, porque ha sido entrenado con toda la información que se encuentra en internet y, por lo tanto, en un lugar u otro, todos los productos relacionados con lo que quieras hacer, aparezcan y se pueda extraer esta información, como realizar un estudio de mercado.

Si impulsamos la automatización de procesos no podemos echar a la calle a la mitad de la población: se debe pensar en cómo revierten en la sociedad los beneficios.

Creo que la IA generativa tiene muchos usos. Hace no mucho, teníamos el caso de una aplicación que “lee” la mente. El tema de las neurociencias y su aplicación en la IA quizás sea también otro salto cualitativo importante en aquello que los humanos podremos automatizar. Por lo tanto, yo diría que las empresas deben asesorarse y, en este sentido, en Catalunya hay un camino, el CIDAI (Centre of Innovation for Data tech and Artificial), una de las patas de la estrategia catalana de IA en su vertiente empresarial. Aquí se agrupan centros tecnológicos y empresas importantes para intentar colaborar y llevar a cabo la parte industrial de la IA. Hay clústers de empresas que no deben asustarse, pero sí ponerse las pilas, informarse y ver cómo esto afecta a su nicho particular. Hasta ahora, la IA había trabajado mucho en vertical, es decir, por ejemplo, el diagnóstico médico. Se hacía un sistema para diagnosticar, se evaluaba, se veía que funcionaba y se ponía a disposición de los profesionales sanitarios, que tenían una ayuda para tener un diagnóstico más preciso. Dependiendo de cada sector industrial en el que estés, hay que ver qué se ha desarrollado en ese sector e intentar utilizar lo que haya.

Otra cosa son los sistemas generativos, que son más transversales, es decir, que no son para un sector en particular, sino que pueden servir para cualquier cosa. ChatGPT o Dall-E se pueden utilizar, en principio, para lo que quieras. Incluso para los expertos, es difícil saber dónde estaremos pasado mañana, pero las empresas deben tener un ojo puesto en los desarrollos que se produzcan.

¿Cuáles son sus aplicaciones más importantes actualmente?

Seguramente son la aplicación en la salud: diagnóstico, automatización de algunos procesos quirúrgicos, sistemas de rehabilitación de enfermos, sistemas de telemedicina (control del estado de los pacientes a distancia)… En todo este sector, la IA tiene usos clarísimos e importantes. En educación, hay multitud de sistemas, pero aquí las cosas van más lentas, porque los gobiernos invierten menos en ello que en salud. Hay sistemas que ayudan en la educación adaptativa, es decir, hacer que un alumno, con sus características particulares, aprenda de manera más eficiente. De hecho, he sido comisario de una exposición en el CaixaForum de Valencia, que precisamente trata sobre IA y educación, donde se enseña una serie de sistemas muy útiles, y esto también tiene un impacto a nivel social.

También se utiliza en farmacología, para ayudar a saber la estructura tridimensional de las proteínas, y antes esto era un trabajo de meses y años. Ahora hay sistemas, como AlphaFold, que en cuestión de segundos te dan la estructura tridimensional de una proteína, y esto quiere decir que el desarrollo de fármacos se acorta de una manera enorme, con un impacto brutal en la industria farmacéutica. Hoy en día, a nadie se le ocurriría ir a buscar la estructura tridimensional de una proteína sin utilizar estos sistemas de inteligencia artificial.

En el análisis de datos procedentes de satélites, en las predicciones meteorológicas. Todos los modelos meteorológicos están utilizando IA, y esto ayuda a mejorar las predicciones.

Según una encuesta reciente, un 80% de la población activa se verá afectada por la IA. ¿Llegará a sustituir las funciones de un profesor, de un periodista o de otros profesionales? ¿Qué otras profesiones pueden peligrar?

Normalmente, la tecnología había automatizado procesos que eran físicos: la máquina de vapor, un avión, un tractor… Todo esto es tecnología que evita que hagamos esfuerzos físicos y mejora mucho nuestra vida. El problema es que ahora hay muchísimas actividades intelectuales que estos sistemas están en fase de automatización. Esto quiere decir que todos los ámbitos de la ocupación humana pueden verse afectados. Pueden verse beneficiados, pero también afectados en el sentido de que haya una mayor eficiencia. Si hay más eficiencia, seguramente se necesitarán menos recursos humanos. Un estudio hablaba de que el 50% de los trabajos que hacemos hoy en día son susceptibles de ser automatizadas con la tecnología que tenemos ya.

Evidentemente, hay trabajos, como ha pasado siempre, que dejarán de tener sentido y que los podrán hacer las máquinas. Como sociedad debemos reflexionar sobre la diferencia en poder automatizar una tarea o querer automatizarla, porque quizás haya trabajos que podamos automatizar pero que son muy gratificantes para los humanos hacerlos. Si los humanos gozamos de hacer esta tarea, ¿por qué tenemos que hacer que la hagan las máquinas? Esto quiere decir que no hemos de dejarlo todo en manos del mercado, sino que es precisa una regulación por parte de los estados, los gobiernos, los parlamentos.

La automatización de estos procesos implicará unos beneficios, y ha de quedar muy claro cómo se repartirán en la sociedad. Para mí, lo que está más en peligro, más que el trabajo de la gente, es el modelo capitalista en que vivimos. Creo que estamos llegando a los límites del modelo y no podemos llegar mucho más allá. Si impulsamos la automatización de procesos no podemos echar a la calle a la mitad de la población y se debe pensar en cómo revierten en la sociedad los beneficios de esto. A lo mejor tendremos que trabajar dos días a la semana haciendo tareas que no nos gustan y el resto del tiempo nos dedicaremos a lo que nos apetezca.

Quizás sea tecnosocialismo, es decir, que la tecnología nos lleve a un mundo mejor, más beneficiosos para los humanos, y tenemos que ver cómo lo hacemos. Tendremos que poner impuestos, impuestos a los robots, seguramente. La tecnología es el resultado de la ciencia y la ciencia es el resultado del esfuerzo colectivo para mejorar las cosas y, por lo tanto, esto debe volver a la sociedad, que es de donde han salido estos avances, y ello implica un cambio de modelo político.

Desde el año 2000, las empresas más importantes del mundo son las tecnológicas, y están provocando unos cambios en la riqueza de los individuos absolutamente bestiales. Tienen más producto interior bruto que los 30 o 40 países más pobres del mundo. ¿Cómo es posible que se acumule tanto poder en estas manos? Por lo tanto, creo que los parlamentos tienen que actuar y empoderarse, y coger las riendas de este tema.